Connect With Us

Sensoren in autonomen Fahrzeugen, sogenannten autonomous vehicle (AV), tragen entschieden dazu bei, die Sicherheit von Fahrern, Passagieren, Radfahrern, Fußgängern und anderen Verkehrsteilnehmern zu erhöhen. Doch verschiedene Wetterbedingungen können die Sensortechnologie einschränken. Forscher und Ingenieure entwickeln Innovationen, um genau diese Einschränkungen zu überwinden.

Radar-, Ultraschall- und LiDAR-Sensoren (LiDAR wird noch im folgenden Text erklärt) sowie im Fahrzeug verbaute Kameras machen es überhaupt erst möglich, dass autonome Fahrzeuge sicher auf den Straßen navigieren. Schlechte Wetterbedingungen können die Navigation allerdings zu einer Herausforderung machen. Es gibt jedoch einige Lösungen, die auch Nebel, Regen und Schnee trotzen. Dabei sind verschiedene Wahrnehmungstechnologien für die gesamtheitliche Bordelektronik vorhanden, die heute in autonomen Fahrzeugen eingesetzt werden.

Wie autonome Fahrzeuge sehen

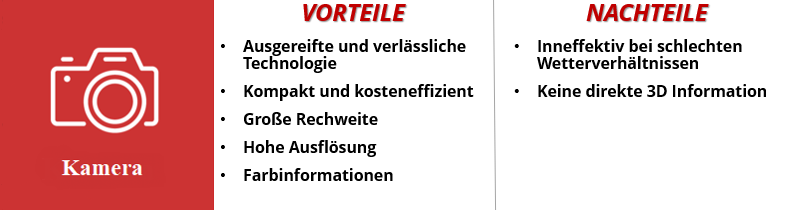

Kameras

Kameras sind ein wesentlicher Bestandteil neuer Fahrzeuge. Sie erleichtern dem Fahrer das Manövrieren und Einparken und sind die Basis für Spurhalteassistenten und adaptive Geschwindigkeitsregler. Mit Hilfe von Software können sie sowohl stehende Objekte wie Straßenmarkierungen und Verkehrsschilder als auch sich bewegende Objekte wie andere Fahrzeuge erkennen und identifizieren.

Allerdings können Kameras Objekte nur dann erkennen, wenn sie beleuchtet sind. Bei schwierigen Umgebungsbedingungen wie Nebel, Schnee, Eis und Dunkelheit werden Kameras in der Regel weniger zuverlässig. Und obwohl sie gute Bilder liefern, sind sie nicht in der Lage, Entfernungen und Abstände zu erkennen.

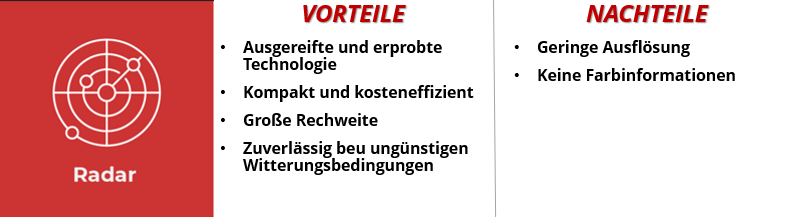

Radar

In der See- und Luftfahrt werden Radargeräte schon seit vielen Jahren eingesetzt. Sensoren schießen Radiowellen in Impulsen auf ein Zielgebiet, die zum Sensor zurückprallen. Dies liefert Informationen über die Geschwindigkeit und den Standort des Objekts. Diese Technologie ermöglicht Fahrerassistenzsysteme wie Kollisionsvermeidung, automatische Notbremsung und adaptive Geschwindigkeitsregelung.

Radarsensoren sind kostengünstig, robust und witterungsbeständig. Ein Schwachpunkt ist jedoch ihre geringe Auflösung. Sie können zwar Objekte erkennen, aber nicht identifizieren oder klassifizieren.

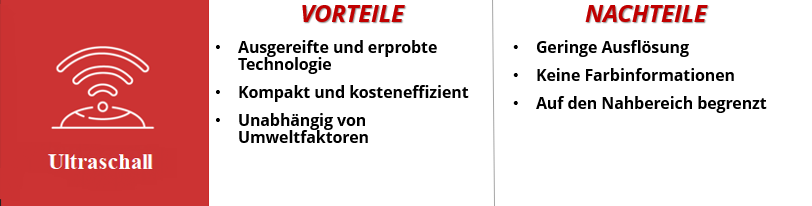

Ultraschall

Mit Hilfe von Hochfrequenz-Schallwellen, die für das menschliche Ohr nicht hörbar sind, messen diese Sensoren Entfernungen und werden häufig für Einparkhilfesysteme verwendet. Sie sind in der Lage, Objekte unabhängig von Farbe und Material zu erkennen und liefern auch bei Nacht und Nebel zuverlässige und präzise Abstandsinformationen. Allerdings kann diese kostengünstige und bewährte Technologie nur im Nahbereich eingesetzt werden.

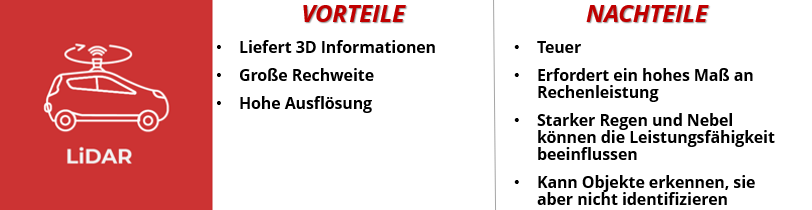

LiDAR

LiDAR bedeutet „Light Detection and Ranging“ und wurde ursprünglich als Vermessungstechnologie entwickelt. Dabei wird unsichtbares Laserlicht verwendet, um die Entfernung zu Objekten zu messen. Diese Sensoren, die bis zu einer Million Laserimpulse pro Sekunde aussenden, erzeugen eine hochauflösende 360-Grad-Ansicht der Umgebung in 3D-Optik.

Es gibt jedoch einen Schwachpunkt: LiDAR-Systeme können durch starken Nebel und heftige Regenfälle beeinträchtigt werden. Die Sensoren benötigen außerdem eine enorme Verarbeitungsleistung, um die Messungen in verwertbare Daten umzuwandeln. LiDAR ist in der Lage zu erkennen, dass es etwas auf der Straße gibt, was ein Hindernis darstellt, allerdings kann der Sensor nicht genau feststellen, um welches Objekt es sich handelt.

LiDAR-Sensoren sind teuer, sie kosten das Zehnfache einer Kamera und eines Radars. Hier ist jedoch eine Veränderung in Sicht. Vor mehr als zehn Jahren brachte das Unternehmen Velodyne den ersten dreidimensionalen LiDAR-Sensor auf den Markt, der damals rund 75.000 Dollar kostete. Das neue Modell des Unternehmens, das kleiner ist als seine Vorgänger und keine beweglichen Teile hat, könnte bei einer Großserienproduktion für rund 100 Dollar verkauft werden.

Anderes Beispiel: Das amerikanische Start-up-Unternehmen Luminar Technologies hat ein kostengünstiges LiDAR entwickelt, das Hard- und Software kombiniert. Das Unternehmen hat zwei Versionen seines sogenannten Iris-Systems für Kunden im Angebot, die preislich zwischen 500 und 1.000 Dollar kosten.

Ein anschauliches Video zum Einsatz der Sensoren gibt es unter:

https://www.youtube.com/watch?v=gEy91PGGLR0

Innovationen bei den Sensoren

Das Wetter mag unberechenbar sein, aber die Sensoren in autonomen Fahrzeugen müssen zuverlässig im Einsatz sein. Mit welchen Innovationen und Forschungsprojekten können Sensoren bei Regen oder Sonnenschein, Hitzewellen oder starkem Schneefall zuverlässig arbeiten?

Sensor-Fusion im Schnee

Die Bewohner der Keweenaw-Halbinsel in Michigan bekommen jeden Winter durchschnittlich mehr als 200 Zentimeter Schnee und sind damit der perfekte Ort, um AV-Technologie zu testen.

Auf der SPIE Defense + Commercial Sensing 2021, eines der großen Branchentreffen für die Optoelektronik, präsentierten Forscher der Michigan Technology University zwei Vorträge, in denen sie Lösungen für autonome Fahrzeuge bei verschneiten Fahrbedingungen diskutierten. Jeder Sensor hat seine Stärken und Grenzen. Durch die Kombination von Daten aus verschiedenen Sensortechnologien werden die Schwächen eines einzelnen Sensortyps beseitigt. Bei diesem Prozess, der so genannten Sensorfusion, wird mithilfe von künstlicher Intelligenz ein einziges Bild oder Modell der Fahrzeugumgebung erstellt.

„Die Sensorfusion nutzt mehrere Sensoren unterschiedlicher Modalitäten, um eine Szene zu verstehen“, sagt Nathir Rawashdeh, Assistenzprofessor für Informatik am College of Computing der Michigan Tech und einer der Forscher der Studie. „Man kann nicht jedes Detail erschöpfend programmieren, wenn die Eingaben schwierige Muster aufweisen“, erklärt Rawashdeh. „Deshalb lassen wir hier künstliche Intelligenz zum Einsatz kommen“, so der Professor.

Das Team um Professor Rawashdeh sammelte Daten vor Ort, indem es ein autonomes Fahrzeug der Michigan Tech unter starken Schneeverhältnissen fuhr. Um der KI-Software beizubringen, wie Schnee aussieht und wie man ihn auch übersehen kann, ging das Team mehr als tausend Bilder von LiDAR-, Radar- und Bilddaten von verschneiten Straßen in Norwegen und Deutschland durch und brachte es der Software bei.

Hier ist ein Begleitvideo zu den Forschungsergebnissen des Teams. Das Video zeigt, wie das KI-Netzwerk die Daten der einzelnen Sensoren verarbeitet und zusammenführt, um befahrbare und nicht befahrbare Bereiche zu identifizieren.

https://www.youtube.com/watch?v=Yfav0WRtp2M&t=45s

Zwei Radargeräte sind besser als eines

Ein Team von Elektroingenieuren an der Universität von Kalifornien in San Diego hat eine Technologie entwickelt, die die Sicht des Radars verbessert.

„Es handelt sich um ein LiDAR-ähnliches Radar“, sagte Dinesh Bharadia, Professor für Elektro- und Computertechnik an der Jacobs School of Engineering der UC San Diego. „Die Verschmelzung von LiDAR und Radar kann auch mit unseren Techniken erfolgen, aber Radare sind nun mal preiswerter. Und insofern müssen wir auf diese Weise keine teuren LiDARs verwenden.“

Auf der Motorhaube des Fahrzeugs werden zwei Millimeter-Radarsensoren angebracht, die einen Abstand von 1,5 Metern haben. Das entspricht der Breite eines durchschnittlichen Autos. Durch diese Anordnung kann das System mehr Raum und Details erkennen als ein einzelner Radarsensor. Um ihr System zu testen, verwendete das Team eine Nebelmaschine. Damit wurde also quasi ein anderes Fahrzeug versteckt. Wie in diesem Video zu sehen ist, konnte das System die 3D-Geometrie des Fahrzeugs genau vorhersagen.

https://www.youtube.com/watch?v=5BrC0Jt4xUc

„Indem wir zwei Radargeräte an verschiedenen Aussichtspunkten mit einem sich überschneidenden Sichtfeld haben, schaffen wir einen Bereich mit hoher Auflösung und einer hohen Wahrscheinlichkeit, die vorhandenen Objekte zu erkennen", erklärt Kshitiz Bansal, Doktorand für Informatik und Ingenieurwesen an der UC San Diego.

Mehr Radargeräte bedeuten aber auch mehr Rauschen: Zufällige Punkte, die nicht zu einem Objekt gehören. Die Sensoren können auch Echosignale auffangen, also Reflexionen von Radiowellen, die nicht von den zu erfassenden Objekten stammen. Um dieses Problem zu lösen, entwickelte das Team neue Algorithmen, die die Daten der beiden Radarsensoren zu einem neuen, rauschfreien Bild kombinieren können.

Das Team der UC San Diego hat auch den ersten Datensatz erstellt, der Daten von zwei Radargeräten kombiniert. Er besteht aus 54.000 Radarbildern von Fahrszenen unter verschiedenen Bedingungen. „Derzeit gibt es keine öffentlich zugänglichen Datensätze mit dieser Art von Daten, die von mehreren Radargeräten mit überlappendem Sichtfeld stammen“, so Bharadia. „Wir haben unsere eigenen Daten gesammelt und einen eigenen Datensatz zum Trainieren unserer Algorithmen und zum Testen erstellt.“

Die Forscher der UC San Diego arbeiten mit dem Autohersteller Toyota zusammen, um ihre Radartechnologie mit Kameras zu kombinieren. Autonome Fahrzeuge könnten die Sicherheit im Straßenverkehr erhöhen, indem sie gefährliches Fahrverhalten oder menschliche Fehler, die Unfälle verursachen, reduzieren. Außerdem bieten sie Menschen mit Behinderungen mehr persönliche Freiheit, da ihnen ermöglicht wird zu fahren, wann und wo sie wollen. Innovationen im Bereich der Sensortechnologien können dazu beitragen, die Straßen sicherer, einfacher und komfortabler für Fahrer, Passagiere und Fußgänger zu machen.

IMI will always be relevant, if not on the leading edge of the next big thing.